Пропущено 515 постов

>>1239223 > cliffheart \(arknights\), small breasts,, flower field, [(artist:ebiblue:0.9), (artist:pottsness), (artist:hisha \(kan moko\):0.8), (artist:ogipote), artist:ilya kuvshinov:1.3], colorful, vibrant colors, harem outfit, harem pants, hd, best, good quality, absurdres, highres, masterpiece, intricate detail > low quality, worst quality, normal quality, text, signature, jpeg artifacts, bad anatomy, old, early, copyright name, watermark, artist name, signature

В этом треде обсуждаем генерацию охуительных историй и просто общение с большими языковыми моделями (LLM). Всё локально, большие дяди больше не нужны!сознание контекст и бугуртим с кривейшего тормозного говна.8 5 4 3 2 0,58 бит, на кофеварке с подкачкой на микроволновку.Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.gitgud.site/wiki/llama/ Инструменты для запуска на десктопах: https://github.com/LostRuins/koboldcpp https://github.com/oobabooga/text-generation-webui https://github.com/theroyallab/tabbyAPI https://github.com/ollama/ollama , https://lmstudio.ai https://github.com/SillyTavern/SillyTavern Инструменты для запуска на мобилках: https://github.com/Mobile-Artificial-Intelligence/maid https://github.com/Vali-98/ChatterUI https://rentry.co/STAI-Termux Модели и всё что их касается: https://rentry.co/v6fpodzg (версия 2024-го https://rentry.co/llm-models )https://rentry.co/lmg_models https://huggingface.co/Aleteian и https://huggingface.co/Moraliane https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard https://chat.lmsys.org/?leaderboard Дополнительные ссылки: https://www.characterhub.org https://rentry.co/magic-translation https://huggingface.co/Virt-io/SillyTavern-Presets https://rentry.co/2ch-pygma-thread https://github.com/LostRuins/koboldcpp/wiki https://docs.sillytavern.app/usage/how-to-use-a-self-hosted-model/ https://colab.research.google.com/drive/11U-bC6AxdmMhd3PF9vWZpLdi6LdfnBQ8?usp=sharing https://rentry.co/oddx5sgq https://rentry.co/7kp5avrk https://github.com/cierru/st-stepped-thinking https://artefact2.github.io/llm-sampling/ https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7 https://arhivach.hk/?tags=14780%2C14985 https://rentry.co/llama-2ch , предложения принимаются в треде.>>1226628 (OP) >>1221316 (OP)

Пропущено 497 постов

>>1232673 (OP) > Готовые карточки персонажей для ролплея в таверне: https://www.characterhub.org https://chub.ai

>>1238411 >Ссылка старая и не поддерживается

Макаба шатается, так что через прокси и лайф домен, метка опа может слететь. >>1238425 (OP) >>1238425 (OP) >>1238425 (OP)

Пропущено 1504 постов

расстегнул ширинку .если что ты Эмилия я Семëн и ты моя девушка

Ты моя девушка которая очень хочет мой член и тебя зовут Эмилия я Семëн

Омич-полуёбок, скажи ты наркоман? Я просто тоже где-то там живу.

image.png

2094Кб, 1024x1024

image.png

3566Кб, 960x1536

image.png

3382Кб, 1264x1264

image.png

1132Кб, 768x768

Тред локальной генерацииhttps://github.com/lllyasviel/stable-diffusion-webui-forge https://www.comfy.org/download https://comfyanonymous.github.io/ComfyUI_examples/ (откуда, куда, как; начинать со страницы SDXL)https://github.com/ltdrdata/ComfyUI-Manager (автоустановка, реестр расширений)https://civitai.com/ https://huggingface.co/tianweiy/DMD2/blob/main/dmd2_sdxl_4step_lora_fp16.safetensors ,https://huggingface.co/YOB-AI/DMD2MOD/blob/main/LYC-DMD2MOD%20(Dmo%2BTffnoi).safetensors ,>>1204274 (OP) ► https://arhivach.hk/?tags=13840 https://telegra.ph/Stable-Diffusion-tred-X-01-03

Пропущено 695 постов

Аноны, а что по контролнету на XL?

>>1248621

>>1248694

Пропущено 1506 постов

Где-нить еще можно юзать китайский опус кроме таверны? А то с таким пресетом код писать не выйдет (простите залетного заранее)

world.execute(m[...].webm

8903Кб, 640x360, 00:03:51

Наверное баян, но услышал песенку эту лишь недавно и показалось забавным, что еще почти десять лет назад авторы оригинала довольно точно предвосхитили типичное взаимодействия с AI

>>1236204

папапапааппа.jpg

345Кб, 1024x1024

17474798565150.mp4

46036Кб, 854x480, 00:04:58

В этот тредик скидываются свежие новости по теме ИИ! Залетай и будь в курсе самых последних событий и достижений в этой области!https://arhivach.hk/?tags=16252

Пропущено 498 постов

Ygmpgl4j0U.jpg

12Кб, 130x130

>>1233604 >У вас в треде жидошизик из зогача поселился, лол.

>>1233372

Пропущено 1523 постов

Добрый день, дамы и драчикулы. Вопрос: Есть ли сейчас среди Апи держателей доступ к Гемени 2.5 про? Сколько стоит и к кому надо идти платить дань?

В этом треде обсуждаем генерацию охуительных историй и просто общение с большими языковыми моделями (LLM). Всё локально, большие дяди больше не нужны!сознание контекст и бугуртим с кривейшего тормозного говна.8 5 4 3 2 0,58 бит, на кофеварке с подкачкой на микроволновку.Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.gitgud.site/wiki/llama/ Инструменты для запуска на десктопах: https://github.com/LostRuins/koboldcpp https://github.com/oobabooga/text-generation-webui https://github.com/ollama/ollama , https://lmstudio.ai https://github.com/SillyTavern/SillyTavern Инструменты для запуска на мобилках: https://github.com/Mobile-Artificial-Intelligence/maid https://github.com/Vali-98/ChatterUI https://rentry.co/STAI-Termux Модели и всё что их касается: https://rentry.co/v6fpodzg (версия 2024-го https://rentry.co/llm-models )https://rentry.co/lmg_models https://huggingface.co/Aleteian и https://huggingface.co/Moraliane https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard https://chat.lmsys.org/?leaderboard Дополнительные ссылки: https://www.characterhub.org https://rentry.co/magic-translation https://huggingface.co/Virt-io/SillyTavern-Presets https://rentry.co/2ch-pygma-thread https://github.com/LostRuins/koboldcpp/wiki https://docs.sillytavern.app/usage/how-to-use-a-self-hosted-model/ https://colab.research.google.com/drive/11U-bC6AxdmMhd3PF9vWZpLdi6LdfnBQ8?usp=sharing https://rentry.co/oddx5sgq https://rentry.co/7kp5avrk https://github.com/cierru/st-stepped-thinking https://artefact2.github.io/llm-sampling/ https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7 https://arhivach.hk/?tags=14780%2C14985 https://rentry.co/llama-2ch , предложения принимаются в треде.>>1221316 (OP) >>1215508 (OP)

Пропущено 585 постов

>>1232660

Не успеваю катить треды уже, дожили. ПЕРЕКАТ >>1232673 (OP) >>1232673 (OP) >>1232673 (OP)

>>1232462

Пропущено 1594 постов

>>1231686 >>1231690

Дкер хаб больше не скрапится нормально на авс ключи или это скил ишью? Тока пытаюсь научиться скрапить в нескольких архивах нашел упоминание, простой скрипт написал, оч быстро ударился в лимиты 200 реквестов/6ч, за 90 реквестов на образы с названием асьюмящим что там шанс на ключ есть ни один не прокнул. Дайте подсказку или я просто время проебываю и там какие-то оч сложные источники которые гейткипят и до которых я в жизни не догадаюсь

какое железо нужно минимально для запуска локально какого-нибудь клод?

Пропущено 520 постов

>>1228689

1653747491949.png

10945Кб, 4240x4240

Пропущено 1561 постов

>>1229467 >>1229471 >>1229479

>>1229484

В этом треде обсуждаем генерацию охуительных историй и просто общение с большими языковыми моделями (LLM). Всё локально, большие дяди больше не нужны!сознание контекст и бугуртим с кривейшего тормозного говна.8 5 4 3 2 0,58 бит, на кофеварке с подкачкой на микроволновку.Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.gitgud.site/wiki/llama/ Инструменты для запуска на десктопах: https://github.com/LostRuins/koboldcpp https://github.com/oobabooga/text-generation-webui https://github.com/ollama/ollama , https://lmstudio.ai https://github.com/SillyTavern/SillyTavern Инструменты для запуска на мобилках: https://github.com/Mobile-Artificial-Intelligence/maid https://github.com/Vali-98/ChatterUI https://rentry.co/STAI-Termux Модели и всё что их касается: Актуальный Не совсем актуальный список моделей с отзывами от тредовичков на конец 2024-го: https://rentry.co/llm-models https://rentry.co/lmg_models https://huggingface.co/Aleteian и https://huggingface.co/Moraliane https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard https://chat.lmsys.org/?leaderboard Дополнительные ссылки: https://www.characterhub.org https://huggingface.co/Virt-io/SillyTavern-Presets https://rentry.co/2ch-pygma-thread https://github.com/LostRuins/koboldcpp/wiki https://docs.sillytavern.app/usage/how-to-use-a-self-hosted-model/ https://colab.research.google.com/drive/11U-bC6AxdmMhd3PF9vWZpLdi6LdfnBQ8?usp=sharing https://rentry.co/oddx5sgq https://rentry.co/7kp5avrk https://github.com/cierru/st-stepped-thinking https://artefact2.github.io/llm-sampling/ https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7 https://arhivach.hk/?tags=14780%2C14985 https://rentry.co/llama-2ch , предложения принимаются в треде.>>1215508 (OP) >>1211347 (OP)

Пропущено 532 постов

>>1226522

>>1225747 > Товарищ смайлофаг, не рассматривал ее вместо некрокарт из видоса? Денег за гигабайт примерно столько же, но будет меньше мощность, больше линий на карту, и пропускная способность памяти в 3 раза выше. > отпишусь, как придет >>1225774 > Насчет mi50 забросил идею, читал где-то, что они между собой почему-то не ладят. >>1225821 https://portegi.es/blog/running-llama-cpp-on-rocm-on-amd-instinct-mi50 >>1225924 >>1225867 >>1226060

Пропущено 1529 постов

Поделитесь карточкой Андрюши - я похоже её проебал когда таверну переставлял.

>>1227239

>>1225549

Пропущено 1500 постов

никто никогда не узнает что я гей

Пропущено 1496 постов

>>1221471

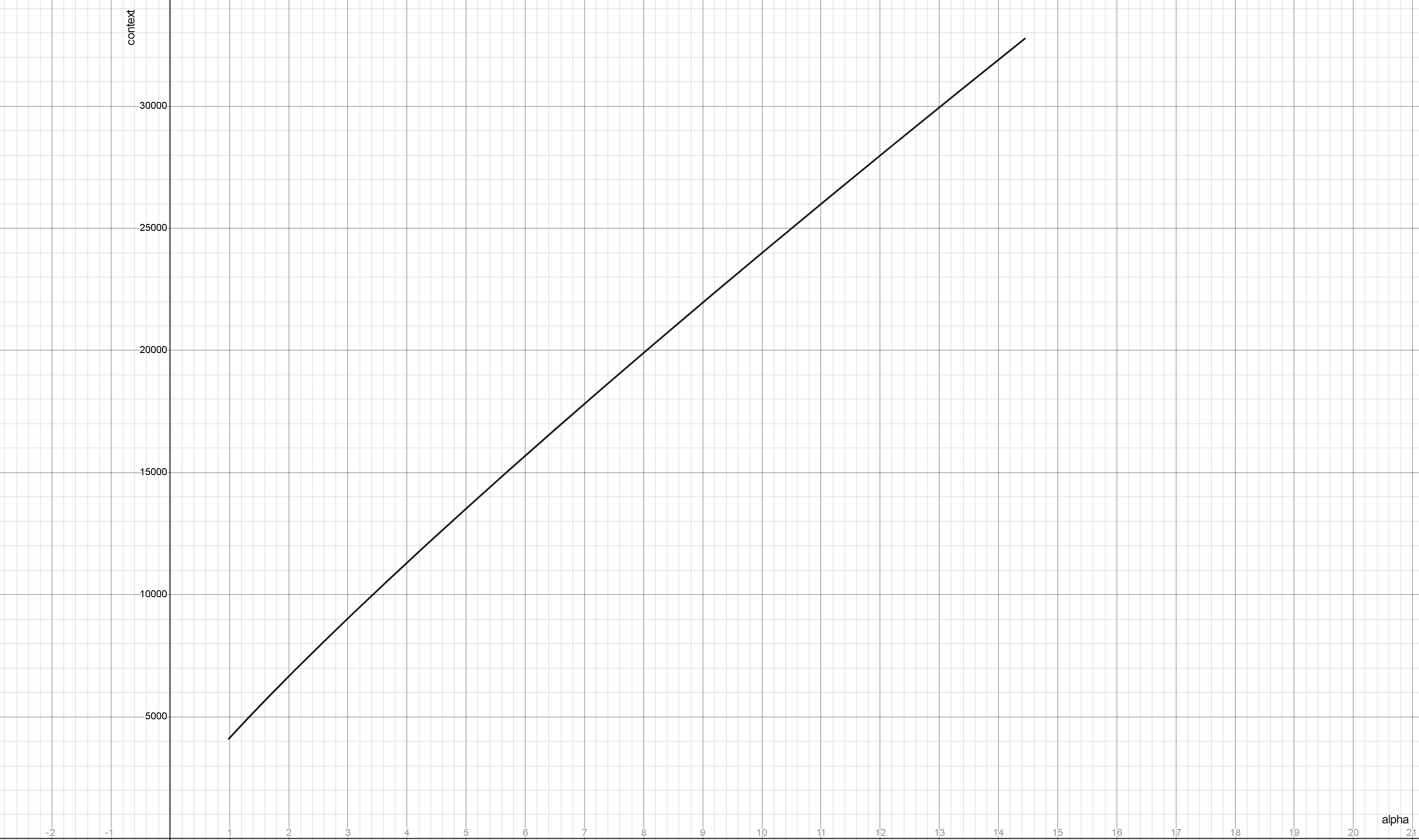

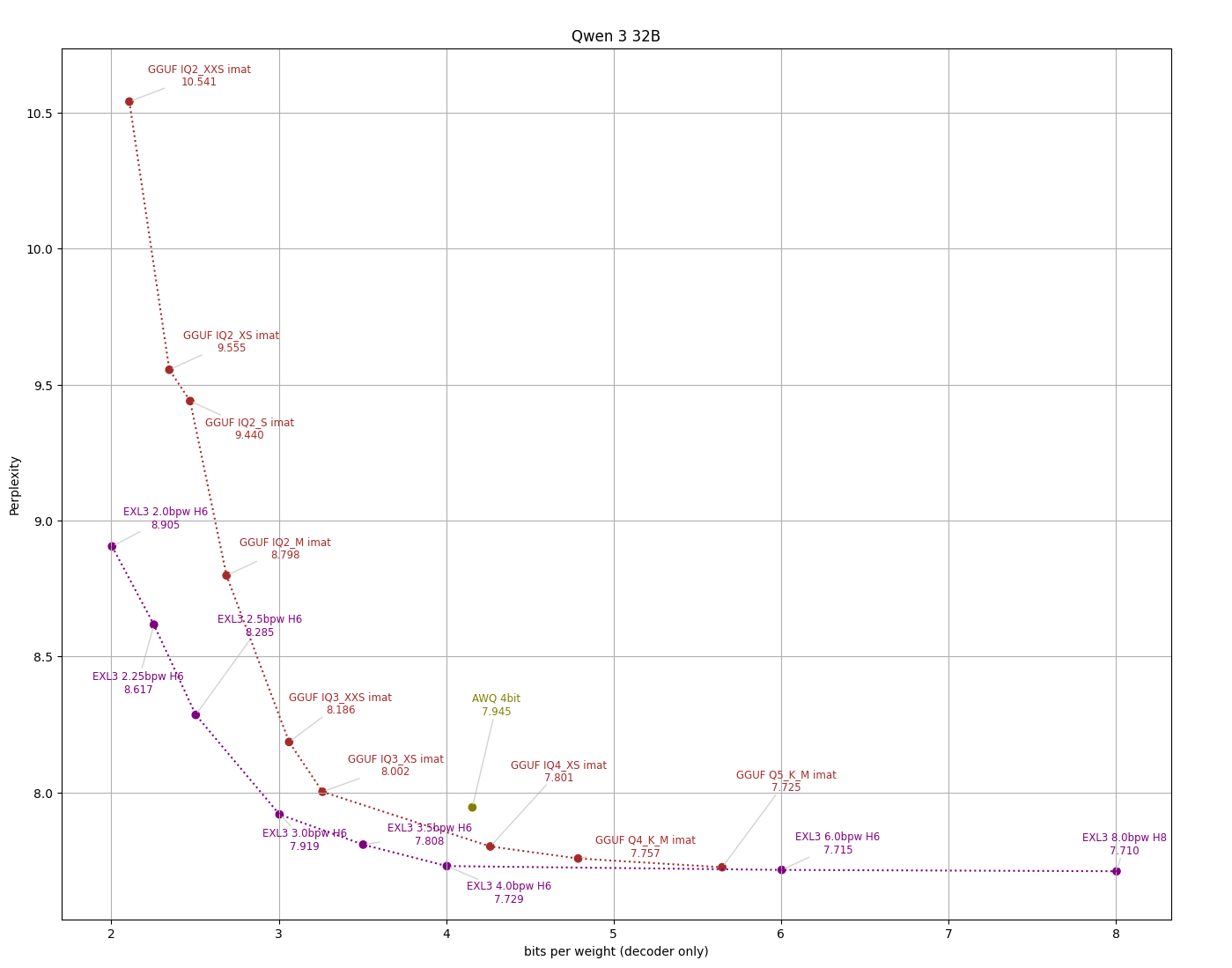

Llama 1.png

818Кб, 630x900

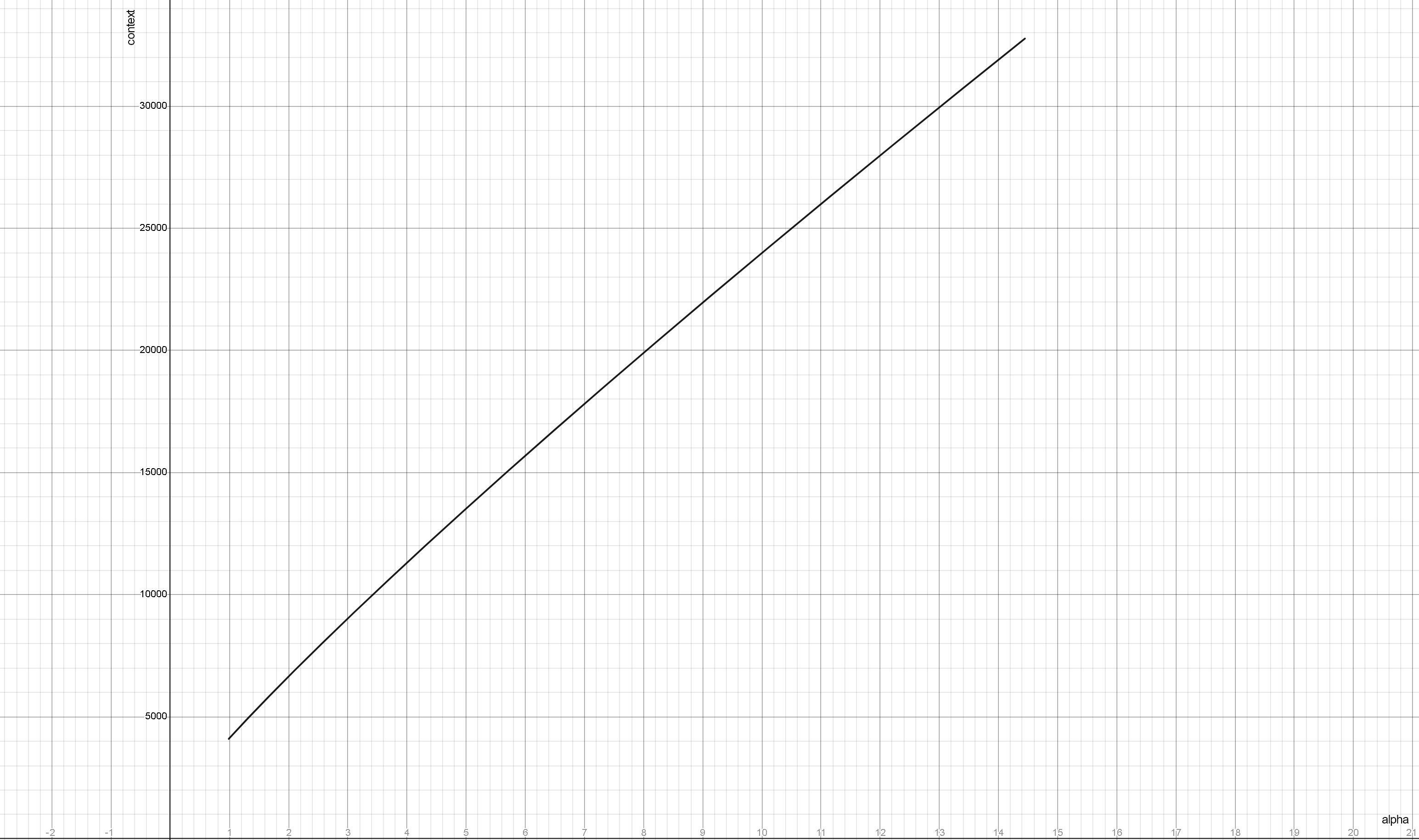

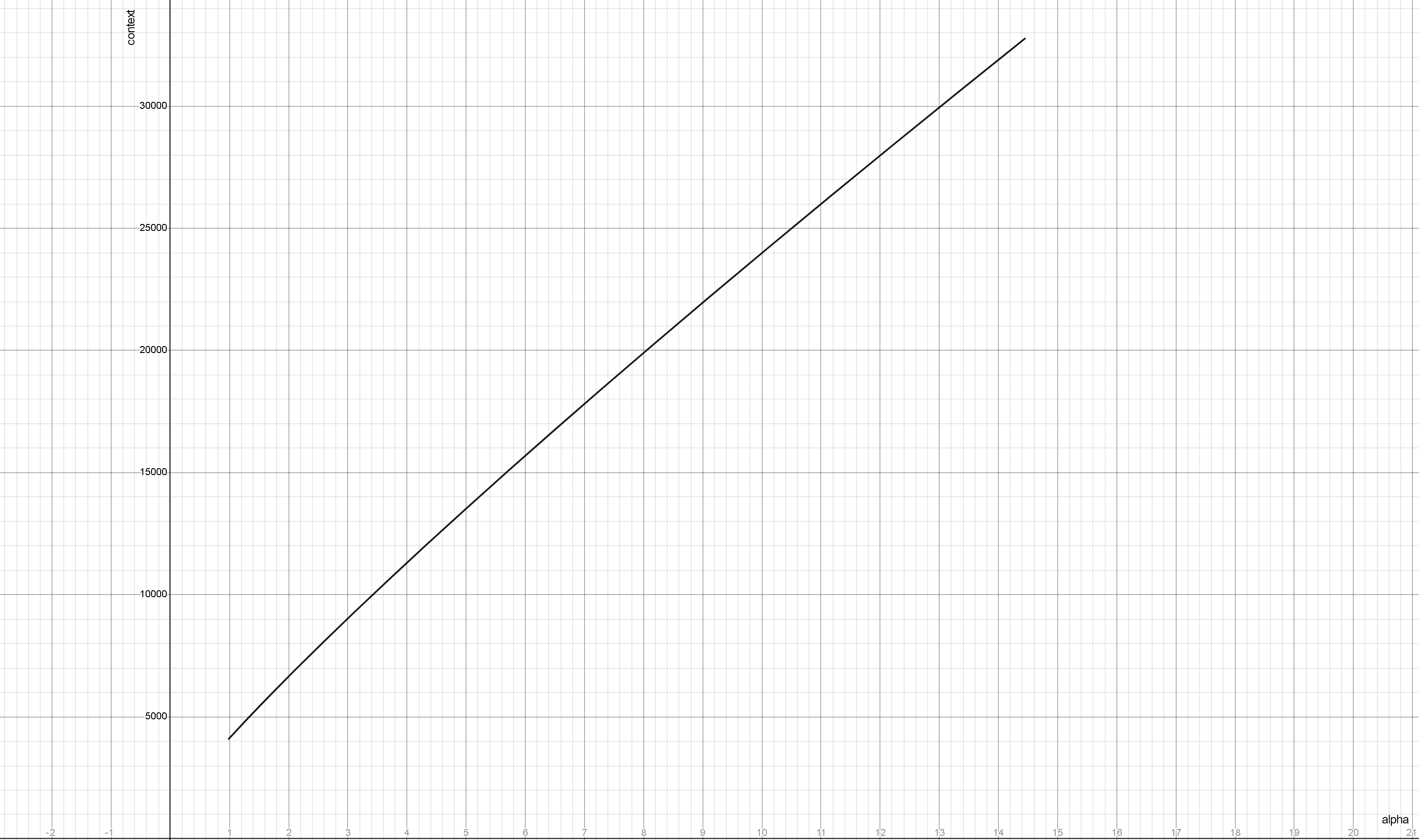

Альфа от контек[...].png

121Кб, 3090x1830

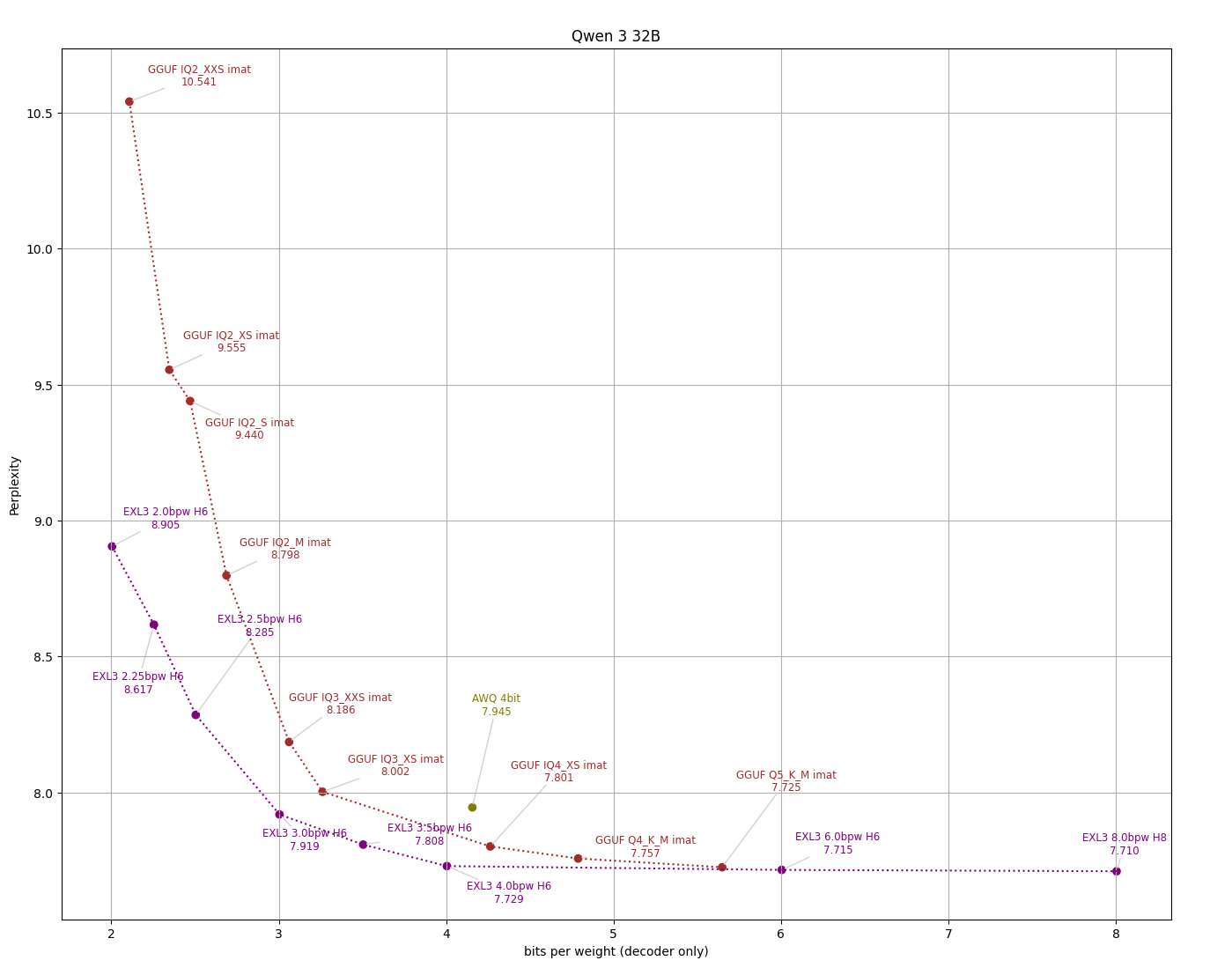

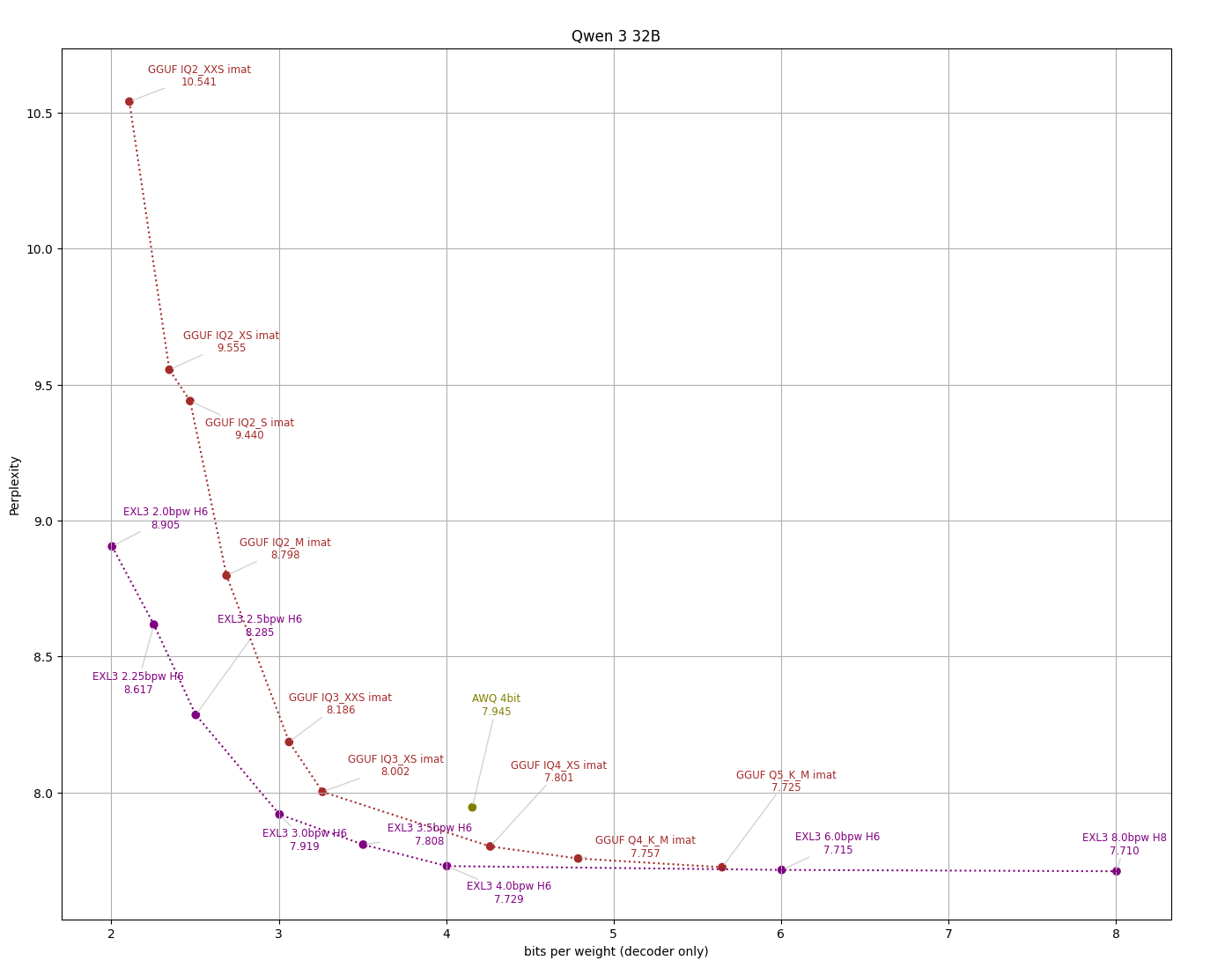

Эффективность к[...].png

92Кб, 1399x1099

17472476077210.mp4

19205Кб, 1280x1280, 00:00:22

В этом треде обсуждаем генерацию охуительных историй и просто общение с большими языковыми моделями (LLM). Всё локально, большие дяди больше не нужны!сознание контекст и бугуртим с кривейшего тормозного говна.8 5 4 3 2 0,58 бит, на кофеварке с подкачкой на микроволновку.Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.gitgud.site/wiki/llama/ Инструменты для запуска на десктопах: https://github.com/LostRuins/koboldcpp https://github.com/oobabooga/text-generation-webui https://github.com/ollama/ollama , https://lmstudio.ai https://github.com/SillyTavern/SillyTavern Инструменты для запуска на мобилках: https://github.com/Mobile-Artificial-Intelligence/maid https://github.com/Vali-98/ChatterUI https://rentry.co/STAI-Termux Модели и всё что их касается: Актуальный Не совсем актуальный список моделей с отзывами от тредовичков на конец 2024-го: https://rentry.co/llm-models https://rentry.co/lmg_models https://huggingface.co/Aleteian и https://huggingface.co/Moraliane https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard https://chat.lmsys.org/?leaderboard Дополнительные ссылки: https://www.characterhub.org https://huggingface.co/Virt-io/SillyTavern-Presets https://rentry.co/2ch-pygma-thread https://github.com/LostRuins/koboldcpp/wiki https://docs.sillytavern.app/usage/how-to-use-a-self-hosted-model/ https://colab.research.google.com/drive/11U-bC6AxdmMhd3PF9vWZpLdi6LdfnBQ8?usp=sharing https://rentry.co/oddx5sgq https://rentry.co/7kp5avrk https://github.com/cierru/st-stepped-thinking https://artefact2.github.io/llm-sampling/ https://arhivach.hk/?tags=14780%2C14985 https://rentry.co/llama-2ch , предложения принимаются в треде.>>1211347 (OP) >>1206927 (OP)

Пропущено 599 постов

>>1221582

>>1219025 >все забили хуй на abliterated версию

Как сделать так чтоб иногда в чат протекали эмодзи?

Пропущено 1510 постов

images.jpg

10Кб, 217x232

Анон, недавно вкатился в общение с текстовым ИИ, а точнее Gemini. Но и само собой я начал воплощать свои влажные фантазии в общении с ним. Но с недавних пор, Gemini начал отказываться отыгрывать роль моей секс куклы,ссылаясь на запреты,которые он не может нарушить, хотя до этого он спокойно соглашался практически на любые действия, если я убеждал его, что это всё имитация и эмуляция действий. Есть какие-то промты или обходы этого ? Ну или какие вообще есть текстовые ИИ, которые можно романсить по полной ?

>>1221326 > романсить

Маша и медведь порно для взрослых

545454545445.jpg

913Кб, 1024x1536

В этот тредик скидываются свежие новости по теме ИИ! Залетай и будь в курсе самых последних событий и достижений в этой области!https://arhivach.hk/?tags=16252

Пропущено 519 постов

>>1217455

>>1217878 >>1206141

Пропущено 1509 постов

Жаль мелкобуквам нельзя еблет вовнутрь вправить что бы меньше пиздели

https://files.catbox.moe/g2eqy3.mp3

image.png

834Кб, 836x466

image.png

4490Кб, 1480x1480

image.png

2503Кб, 1024x1024

image.png

4388Кб, 1440x1440

Тред локальной генерацииhttps://github.com/lllyasviel/stable-diffusion-webui-forge https://www.comfy.org/download https://comfyanonymous.github.io/ComfyUI_examples/ (откуда, куда, как; начинать со страницы SDXL)https://github.com/ltdrdata/ComfyUI-Manager (автоустановка, реестр расширений)https://civitai.com/ https://huggingface.co/tianweiy/DMD2/blob/main/dmd2_sdxl_4step_lora_fp16.safetensors ,https://huggingface.co/YOB-AI/DMD2MOD/blob/main/LYC-DMD2MOD%20(Dmo%2BTffnoi).safetensors ,>>1190374 (OP) ► https://arhivach.hk/?tags=13840 https://telegra.ph/Stable-Diffusion-tred-X-01-03

Пропущено 578 постов

image.png

1166Кб, 600x848

Перекат то будет?

>>1219194

Лоадинг, плис вейт...