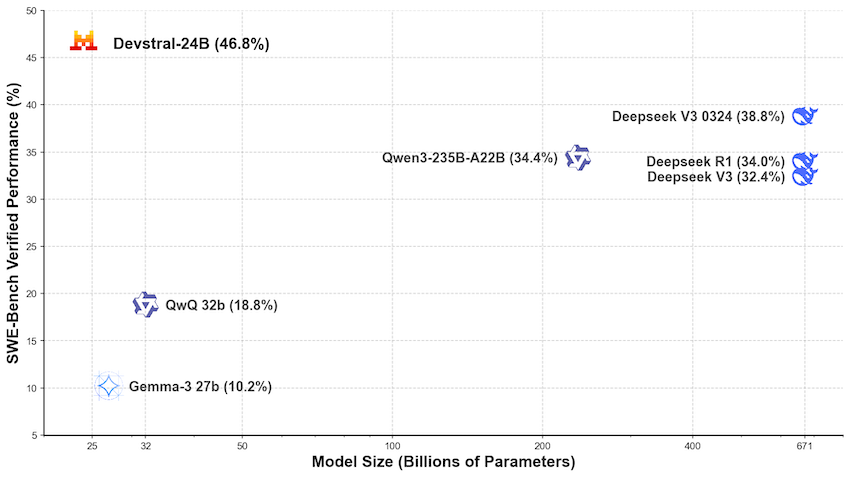

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №132 /llama/

Аноним

18/05/25 Вск 14:01:33

№

1