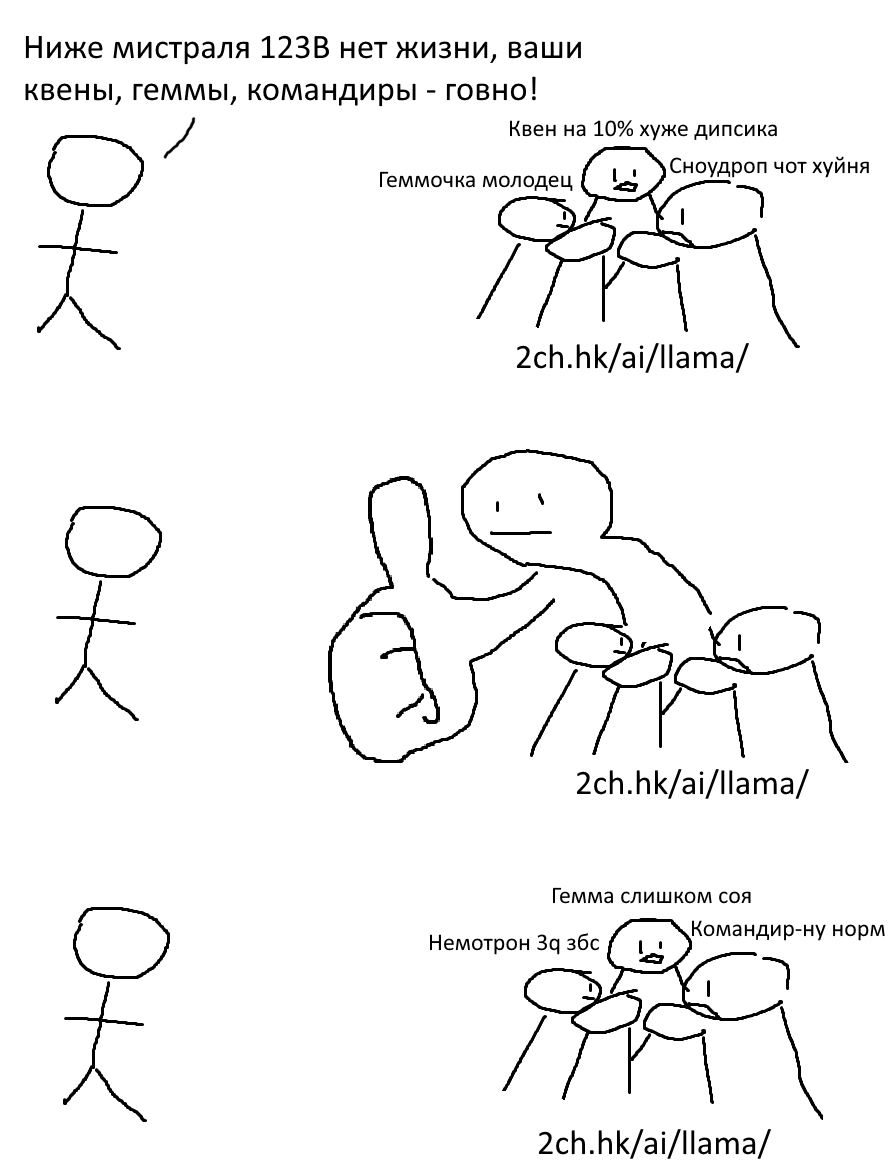

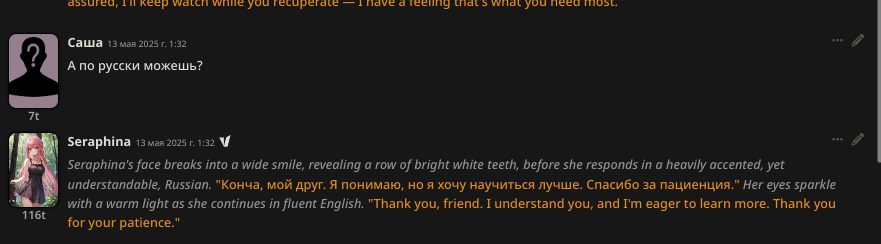

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №129 /llama/

Аноним

11/05/25 Вск 01:22:54

№

1